Расчеты показывают, что управлять сверхразумным искусственный интеллект будет невозможно

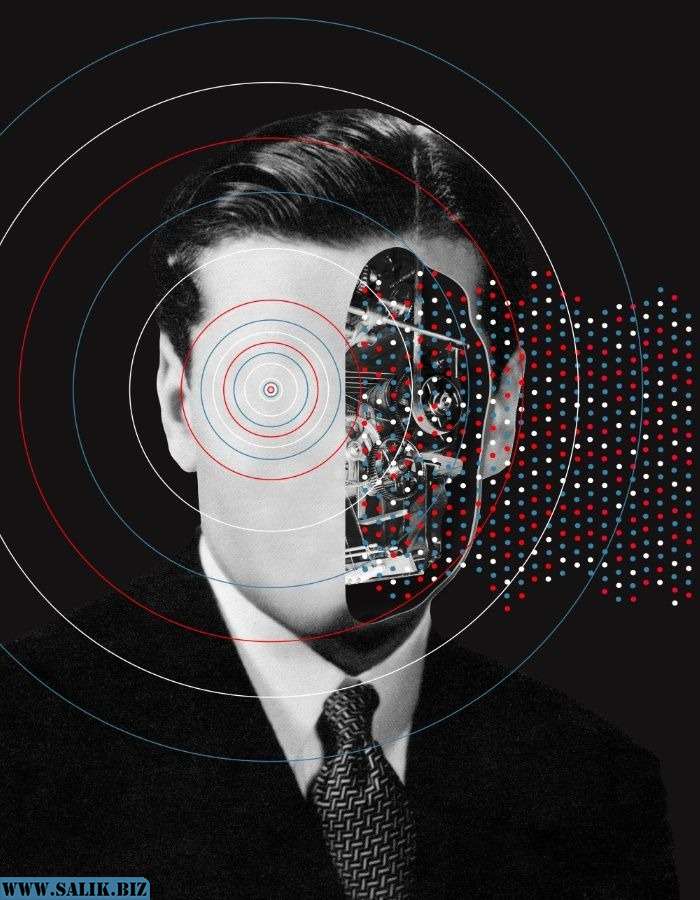

Идея об искусственном интеллекте, свергающем человечество, обсуждалась на протяжении многих десятилетий, и ученые только что вынесли свой вердикт о том, сможем ли мы контролировать высокоуровневый компьютерный супер-интеллект.

Ответ? Почти наверняка нет.

Загвоздка в том, что для управления сверхразумом, выходящим далеко за пределы человеческого понимания, потребуется симуляция этого сверхразума, которую мы можем проанализировать. Но если мы не в состоянии это понять, невозможно создать такую симуляцию.

Такие правила, как «не причиняйте вреда людям», невозможно установить, если мы не понимаем, какие сценарии будет предлагать ИИ, — предполагают авторы новой статьи. Когда компьютерная система работает на уровне, превышающем возможности наших программистов, мы больше не можем устанавливать ограничения.

«Супер-интеллект представляет собой принципиально другую проблему, чем те, которые обычно изучаются под лозунгом «этики роботов», — пишут исследователи.

«Это потому, что суперинтеллект многогранен и, следовательно, потенциально способен мобилизовать разнообразные ресурсы для достижения целей, которые потенциально непонятны для людей, не говоря уже о том, чтобы их можно было контролировать».

Часть рассуждений команды исходит из проблемы остановки, выдвинутой Аланом Тьюрингом в 1936 году. Проблема заключается в знании того, придет ли компьютерная программа к выводу и ответу (поэтому она останавливается) или просто зацикливается на бесконечности, пытаясь найти ответ.

Как доказал Тьюринг, хотя мы можем знать, что для некоторых конкретных программ, логически невозможно найти способ, который позволил бы нам узнать это для каждой потенциальной программы, которая когда-либо могла быть написана. Это возвращает нас к ИИ, который в сверхразумном состоянии мог реально удерживать в своей памяти сразу все возможные компьютерные программы.

Любая программа, написанная, например, для того, чтобы остановить ИИ, причиняющей вред людям и разрушающий мир, может прийти к выводу (и остановиться) или нет — для нас математически невозможно быть абсолютно уверенным в любом случае, а это означает, что ее невозможно контролировать.

«По сути, это делает алгоритм контроля непригодным для использования», — говорит ученый Ияд Рахван из Института развития им. Макса Планка в Германии.

«Поэтому возникает вопрос, может ли это в какой-то момент стать неконтролируемым и опасным для человечества».

Исследование было опубликовано в Journal of Artificial Intelligence Research.